Pour comprendre ce qu’est un biais en intelligence artificielle (IA), imaginez que vous êtes en train de préparer un gâteau. Vous suivez scrupuleusement la recette, mais à la fin, le gâteau n’est pas aussi délicieux que prévu. Pourquoi ? Peut-être que les ingrédients que vous avez utilisés n’étaient pas de bonne qualité ou que vous avez fait des erreurs dans les proportions. En IA, les biais fonctionnent de manière similaire. Un biais en IA est une forme de préférence ou d’injustice involontaire qui peut apparaître dans les décisions prises par un modèle d’IA. Ces biais surviennent souvent parce que l’IA a été entraînée sur des données qui contiennent déjà ces préférences ou inégalités.

Les biais en IA ne sont pas toujours évidents à détecter, mais leurs effets peuvent être profonds et durables. Par exemple, un modèle de reconnaissance vocale qui fonctionne parfaitement pour les accents américains pourrait avoir des difficultés à comprendre les accents régionaux français. Ce type de biais peut rendre certaines technologies inutilisables pour une partie de la population, créant ainsi une fracture numérique.

Comment les biais apparaissent-ils ?

Les biais peuvent surgir à plusieurs étapes du processus de création et d’utilisation d’une IA. Pour mieux comprendre, prenons un exemple concret : si les données utilisées pour entraîner une IA ne sont pas équilibrées ou représentatives, cela peut conduire à des résultats qui favorisent certaines personnes, groupes ou idées au détriment d’autres. Par exemple, un modèle de reconnaissance faciale entraîné principalement avec des visages de personnes blanches risque de fonctionner moins bien pour des personnes ayant une peau plus foncée. Ce type de biais peut avoir des conséquences graves, notamment dans les domaines de la sécurité et de la justice.

Mais ce n’est pas tout. Les choix faits par les développeurs lors de la conception de l’IA peuvent également introduire des biais. Par exemple, un algorithme de recrutement qui met trop l’accent sur des critères comme « l’école où une personne a étudié » pourrait ignorer des candidats talentueux qui n’ont pas suivi cette trajectoire. Ce biais peut perpétuer des inégalités sociales et économiques en excluant des candidats qualifiés mais non traditionnels.

Même si un modèle est bien conçu, son utilisation dans un contexte spécifique peut introduire des biais. Par exemple, un outil médical IA utilisé dans une région où la population a des caractéristiques différentes de celles sur lesquelles il a été entraîné pourrait faire des prédictions incorrectes. Ce type de biais peut mettre en danger la vie des patients en fournissant des diagnostics erronés.

Exemples concrets de biais en IA

Pour mieux comprendre ce concept, voici quelques exemples concrets :

- Biais racial : Un système de reconnaissance faciale a été critiqué car il avait du mal à identifier correctement les visages de femmes noires. Cela s’est produit parce que les données d’entraînement comprenaient principalement des visages d’hommes blancs. Ce type de biais peut avoir des conséquences graves, notamment dans les domaines de la sécurité et de la justice. Par exemple, une personne innocente pourrait être faussement accusée en raison d’une erreur de reconnaissance faciale.

- Biais de genre : Certains modèles de traitement du langage naturel associent certains mots professionnels (comme « ingénieur » ou « docteur ») aux hommes et d’autres (comme « infirmière » ou « enseignante ») aux femmes. Cela reflète les stéréotypes présents dans les données d’entraînement. Ces biais peuvent perpétuer des inégalités de genre dans le monde professionnel. Par exemple, un algorithme de recommandation d’emploi pourrait suggérer des postes moins rémunérés aux femmes en raison de ces stéréotypes.

- Biais économique : Un algorithme de crédit peut refuser des prêts à des personnes vivant dans certaines zones géographiques simplement parce que ces zones ont historiquement eu moins d’accès aux services financiers. Ce type de biais peut exacerber les inégalités économiques et sociales. Par exemple, une personne qualifiée pour un prêt pourrait se voir refuser en raison de son code postal.

- Biais culturel : Un traducteur automatique pourrait traduire « elle est un médecin » en « il est un médecin » dans certaines langues, car les données d’entraînement contiennent davantage d’exemples de médecins masculins. Ce biais peut renforcer des stéréotypes culturels et nuire à la précision des traductions. Par exemple, une traduction incorrecte pourrait entraîner des malentendus dans des contextes professionnels ou médicaux.

Pourquoi les biais en IA sont-ils problématiques ?

Les biais en IA peuvent avoir des conséquences importantes. Ils peuvent amplifier les inégalités existantes dans la société, entraînant ainsi une injustice sociale. Si une IA est perçue comme injuste ou discriminatoire, les gens perdent confiance dans cette technologie. De plus, les biais peuvent entraîner des erreurs dans des domaines critiques comme la santé, la justice ou le recrutement. Par exemple, un algorithme de diagnostic médical biaisé pourrait mettre en danger la vie des patients en fournissant des diagnostics incorrects.

Les biais en IA peuvent également avoir des répercussions économiques. Une entreprise qui utilise un algorithme de recrutement biaisé pourrait passer à côté de talents précieux, ce qui pourrait nuire à sa compétitivité sur le marché. De plus, les coûts associés à la correction des erreurs causées par des biais peuvent être considérables. Par exemple, une entreprise pourrait faire face à des poursuites judiciaires si un algorithme de crédit biaisé refuse des prêts à des clients qualifiés.

Comment réduire les biais en IA ?

Heureusement, il existe plusieurs approches pour minimiser les biais dans les systèmes d’IA. Tout d’abord, il est crucial d’utiliser des données diversifiées pour s’assurer que les données d’entraînement représentent tous les groupes concernés de manière équitable. Cela signifie inclure des données provenant de différentes régions, cultures, genres et groupes socio-économiques. Ensuite, il est important d’auditer régulièrement les modèles pour détecter et corriger les biais avant leur déploiement. Les audits doivent être effectués par des équipes diversifiées pour garantir une perspective large et équilibrée.

La formation des développeurs est également essentielle. Sensibiliser les équipes techniques aux questions d’éthique et de biais permet de prendre ces aspects en compte dès la conception. Les développeurs doivent être formés à reconnaître les biais potentiels et à utiliser des techniques pour les atténuer. Par exemple, ils peuvent apprendre à utiliser des algorithmes de réduction des biais ou à concevoir des modèles plus inclusifs.

La transparence joue aussi un rôle clé : expliquer comment les décisions de l’IA sont prises permet aux utilisateurs de comprendre et de remettre en question les résultats si nécessaire. Les entreprises doivent être transparentes sur les données utilisées pour entraîner leurs modèles et sur les processus de prise de décision. Cela peut inclure la publication de rapports sur les biais détectés et les mesures prises pour les corriger.

Enfin, la collaboration interdisciplinaire est indispensable. Impliquer des experts en sociologie, éthique et droit dans le développement des systèmes d’IA garantit une perspective plus large et plus équilibrée. Par exemple, un sociologue pourrait identifier des biais culturels que les développeurs n’auraient pas remarqués. Les experts en éthique peuvent aider à élaborer des lignes directrices pour garantir que les systèmes d’IA respectent les droits de l’homme et les principes de justice sociale.

Conclusion

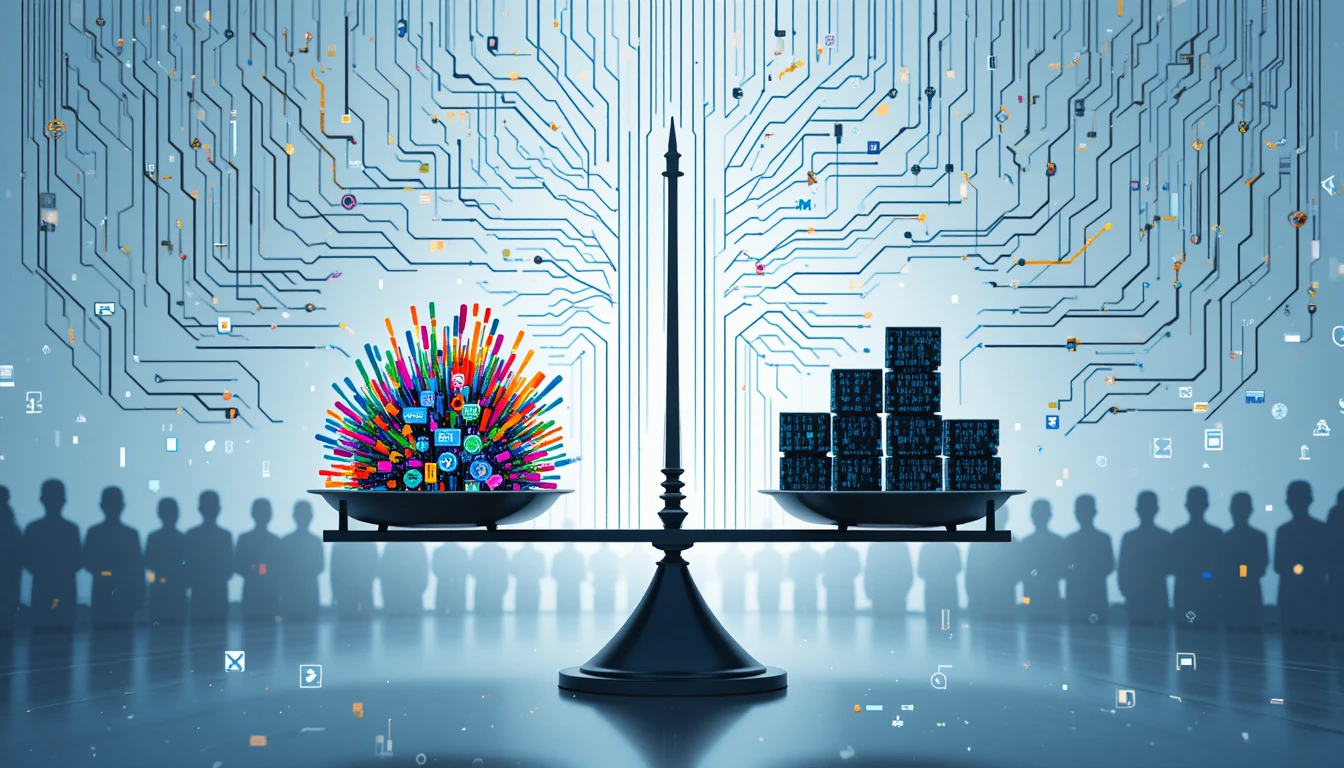

Les biais en IA sont des préférences ou injustices involontaires qui peuvent apparaître lorsque les modèles sont entraînés sur des données imparfaites ou mal conçues. Ces biais peuvent avoir des impacts significatifs sur la vie quotidienne, mais ils peuvent être réduits grâce à une attention accrue portée aux données, à la conception et à l’utilisation des systèmes d’IA.

En somme, il est essentiel de veiller à ce que les technologies d’IA soient justes, équitables et bénéfiques pour tous. Cela nécessite un effort concerté de la part des développeurs, des entreprises et des régulateurs pour identifier et atténuer les biais à chaque étape du processus de développement et de déploiement de l’IA. En adoptant une approche proactive et inclusive, nous pouvons créer des systèmes d’IA qui respectent les valeurs de justice et d’équité et qui bénéficient à l’ensemble de la société.